使用 One API 集成 GenStudio API

本教程将指导用户如何在 One API 平台集成 GenStudio 的 API 服务。

获取 GenStudio API Key

您可以复制已有 API Key 或创建新的 Key。

预置模型 API 服务有 API 频率限制。租户在 GenStudio 的服务等级决定了 API 调用是否计费,以及享受的 API 频率上限。详见 LLM API 计费规则

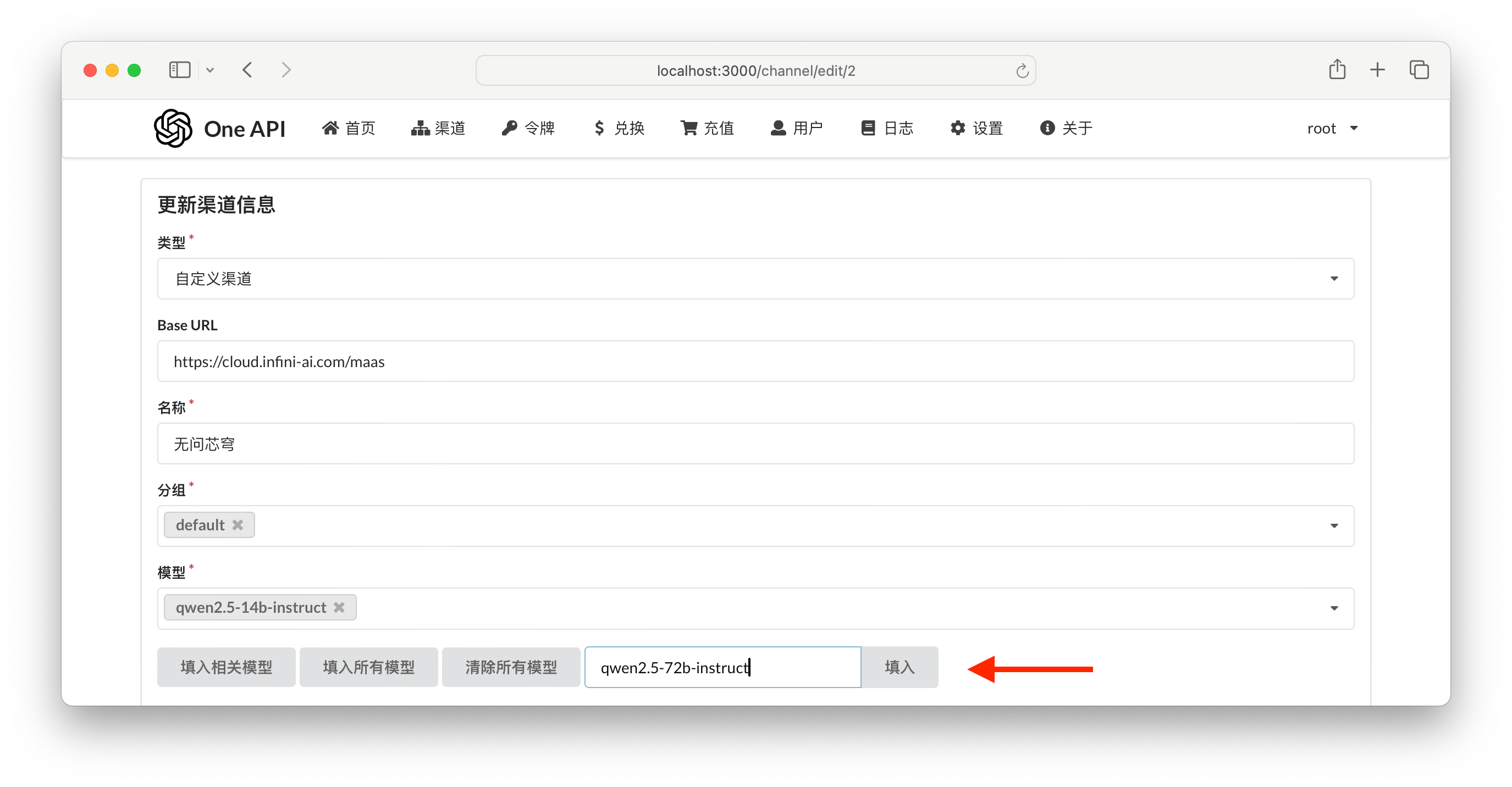

创建自定义渠道

One API 并未内置无问芯穹 GenStudio API 服务。必须通过自定义渠道集成。

以下为必填选项,其他可根据需要进行自定义。

- 类型:必须选择「自定义渠道」。

- Base URL:必须配置为

https://cloud.infini-ai.com/maas。 - 模型:请从 GenStudio 模型广场 获取模型名称。仅支持大语言模型。例如:

qwen2.5-7b-instructqwen2.5-14b-instructqwen2.5-32b-instructqwen2.5-72b-instruct

- API Key 密钥:获取 GenStudio API 密钥。

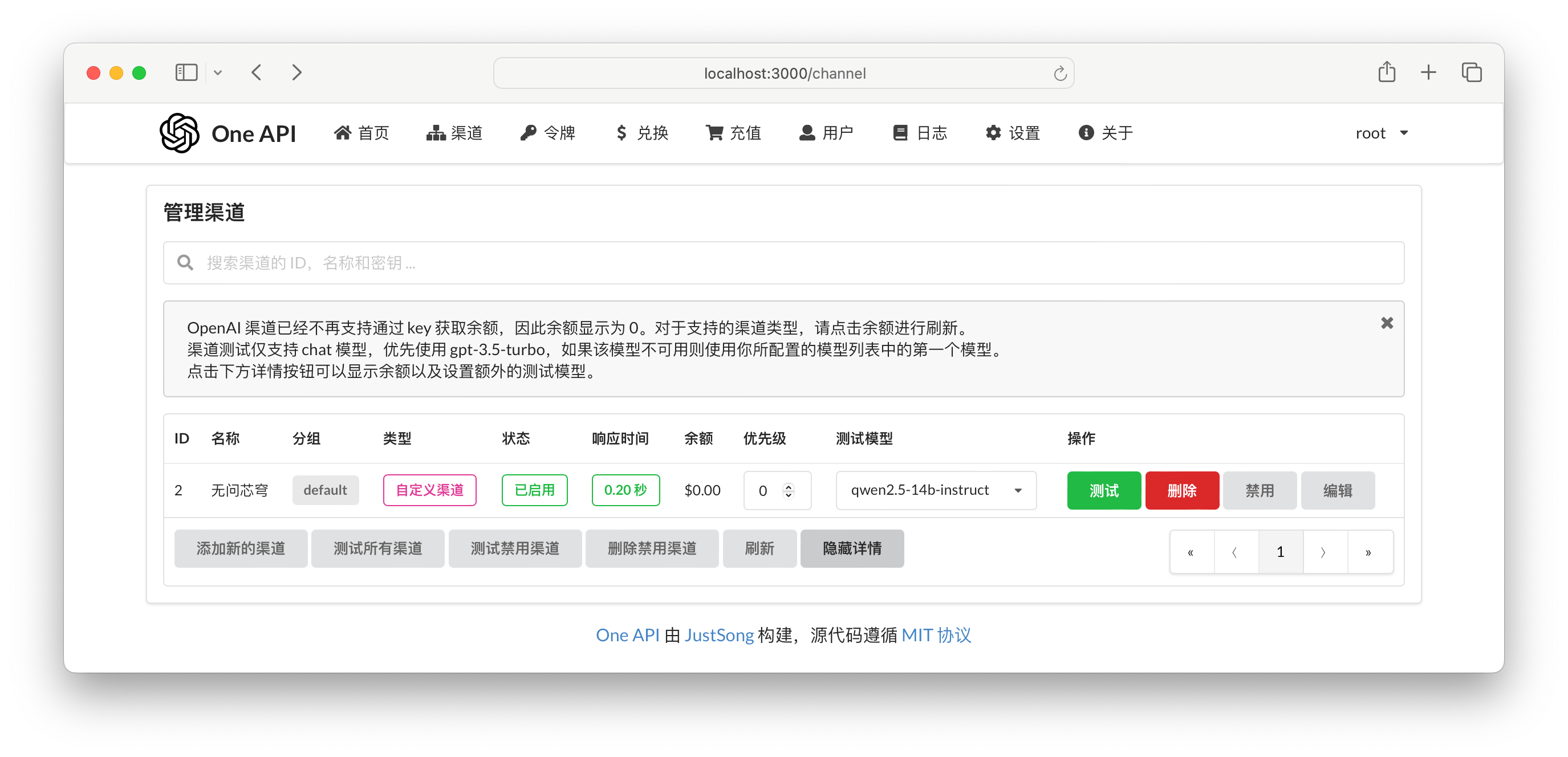

测试连通性

配置成功后如图。请务必进行测试。

测试成功即配置正确,至此已完成所有配置。

注意

如果想了解如何在一站式 AI 平台(AIStudio)部署 one-api 项目,可以继续查看下方教程。

在 AIStudio 中部署 one-api

一站式 AI 平台(AIStudio)开发机提供了含 GPU 开发机环境,您可以在 AIStudio 开发机上部署 one-api 项目和 Ollama 等本地推理项目。

改造 Dockerfile

one-api 项目直接提供了 Dockerfile,但该文件直接依赖了 DockerHub 的镜像,在国内网络环境下无法拉取镜像,因此需要对该文件进行改造。此外,我们还需要针对国内情况调整 NPM 和 Go 的设置。

针对 DockerHub 镜像的问题,建议您提前获取构建过程中依赖的镜像,存入自己的租户镜像仓库。本次 Dockerfile 示例中的基础镜像已被替换为租户 te-b905754427352261 的私有镜像:

cr.infini-ai.com/te-b905754427352261/node:22cr.infini-ai.com/te-b905754427352261/golang:alpinecr.infini-ai.com/te-b905754427352261/alpine:latest

完整的 Dockerfile(仅作为示例,请务必自行替换 FROM 语句中的镜像地址):

FROM cr.infini-ai.com/te-b905754427352261/node:22 AS builder

# 克隆 one-api 代码仓库

WORKDIR /app

RUN git clone https://ghfast.top/https://github.com/songquanpeng/one-api.git .

RUN echo "registry=https://registry.npmmirror.com" > .npmrc

WORKDIR /app/web

WORKDIR /app/web/default

RUN npm install

RUN DISABLE_ESLINT_PLUGIN='true' REACT_APP_VERSION=$(cat ../../VERSION) npm run build

WORKDIR /app/web/berry

RUN npm install

RUN DISABLE_ESLINT_PLUGIN='true' REACT_APP_VERSION=$(cat ../../VERSION) npm run build

WORKDIR /app/web/air

RUN npm install

RUN DISABLE_ESLINT_PLUGIN='true' REACT_APP_VERSION=$(cat ../../VERSION) npm run build

FROM cr.infini-ai.com/te-b905754427352261/golang:alpine AS builder2

RUN apk add --no-cache g++ git

ENV GO111MODULE=on \

CGO_ENABLED=1 \

GOOS=linux \

GOPROXY=https://goproxy.cn,direct

WORKDIR /build

# 从上一个阶段获取构建产物

COPY --from=builder /app/go.mod /app/go.sum ./

RUN go mod download

COPY --from=builder /app/ .

COPY --from=builder /app/web/build ./web/build

RUN go build -trimpath -ldflags "-s -w -X 'github.com/songquanpeng/one-api/common.Version=$(cat VERSION)' -extldflags '-static'" -o one-api

FROM cr.infini-ai.com/te-b905754427352261/alpine:latest

RUN apk update \

&& apk upgrade \

&& apk add --no-cache ca-certificates tzdata \

&& update-ca-certificates 2>/dev/null || true

COPY --from=builder2 /build/one-api /

EXPOSE 3000

WORKDIR /data

CMD ["/bin/sh"]构建自定义镜像

前往镜像中心,选择使用 Dockerfile 构建镜像。填入您改造后的 Dockerfile,构建自定义镜像,后续用于启动 AIStudio 开发机。

启动 one-api

创建 AIStudio 开发机,使用自定义镜像。登录后,执行以下命令。

cd /

chmod u+x ./one-api

./one-api --port 3000 --log-dir ./logs访问 Web UI:

- 使用开发机的预览 Web 应用功能,直接从智算云平台打开预览页面。详见预览开发机上运行的 Web 应用。使用该方式生成的预览链接,要求已登录 AIStudio 账号。

- 如果想避免 AIStudio 平台账号认证,可在本地计算机命令行终端设置端口转发。详见 SSH 端口转发。

常见问题

如何配置 GenStudio M × N API 接口?

暂不支持在 One API 中接入 GenStudio M × N 多模型芯片 Chat Completions。

如何配置 GenStudio Embeddings 接口?

暂不支持在 One API 中接入 GenStudio Embeddings 接口。

如何配置自部署的大语言模型 API 服务?

暂不支持在 One API 中接入 GenStudio 自部署模型 Chat Completions。