预置模型列表

大模型服务平台(GenStudio)预置了来源于诸多厂商的主流系列模型。

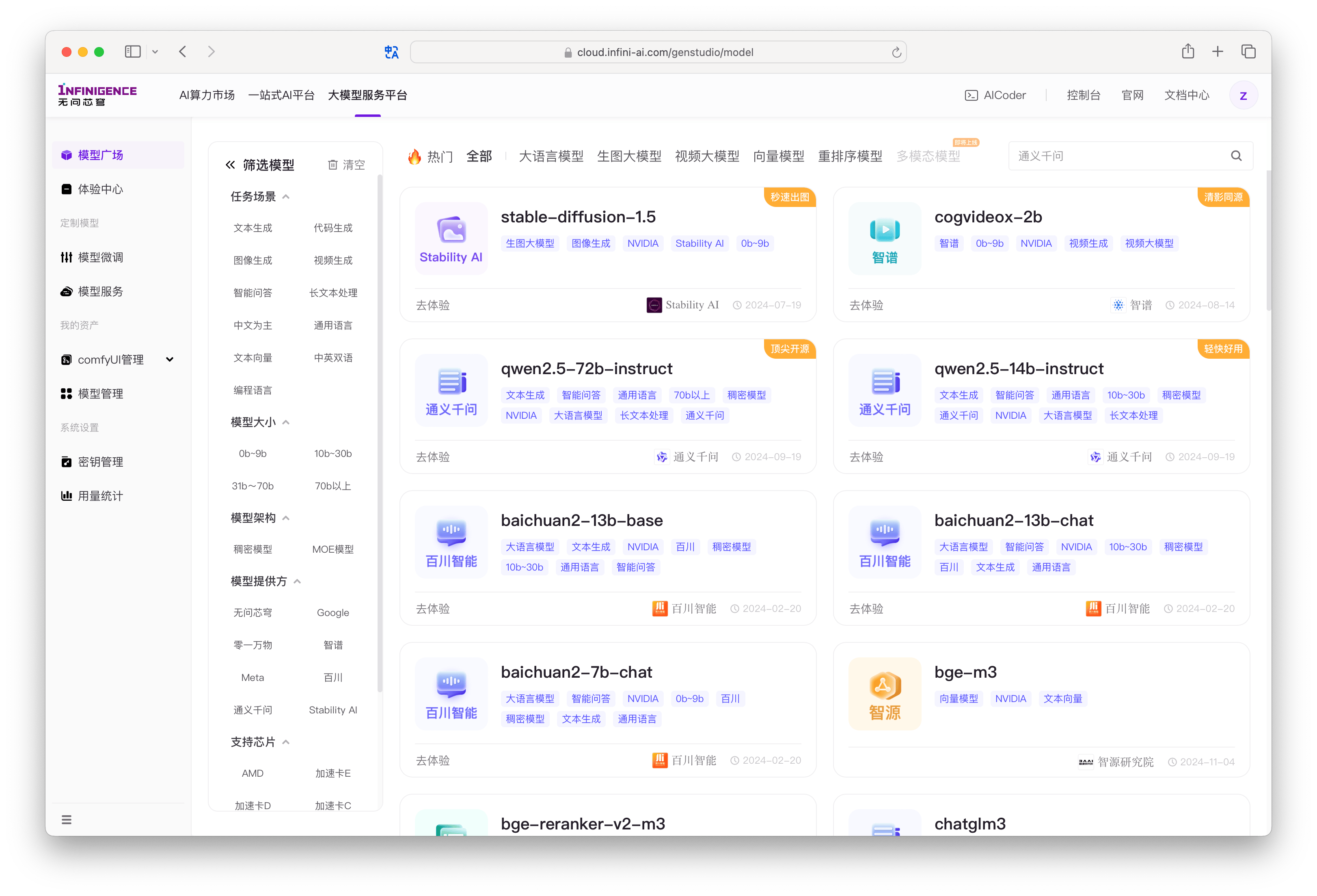

访问模型广场

模型广场页面集中展示大模型服务平台(GenStudio)预置的模型。您可以通过模型广场顶部与左侧的标签筛选模型。每个预置大模型均以卡片的形式呈现。

模型名称一般与模型厂商命名保持一致。您可以从模型卡片标签中直接查看模型所属厂商、支持的芯片、适用场景、上下文长度等信息。

模型卡片左下角可能带有以下便捷入口:

- 可体验:可直接进入体验中心,开启互动体验,例如对话、生成图像、生成视频等。大语言模型支持配置 System Prompt 和其他参数。图像和视频模型暂仅支持随机预置提示词,可修改基本参数。

- 可微调:支持 GenStudio 快捷微调服务。

点击模型卡片进入详情页,可查看模型介绍、上下文长度(context length)、最大生成长度(max tokens)。如果该预置模型提供 API 服务,将提供调用说明、调用示例等。

预置模型类型与能力

预置模型指由模型厂商发布、由 GenStudio 平台预集成并维护的模型服务。大模型服务平台(GenStudio)预置了多种主流模型,您可以通过模型广场页面顶部切换到不同的分类,包括但不限于:

- 大语言模型

- 生图大模型

- 视频大模型

- 向量模型

- 重排序模型

- 多模型模型

- 语音大模型

模型广场左侧提供了更细致的筛选条件,例如:

- 任务场景(文本生成、代码生成、视觉理解等不同任务)

- 模型大小(0b~9b、10b-30b 等不同参数量区间)

- 上下文长度(模型 API 服务支持的 context length)

- 模型提供方

预置模型会不定期更新,最新的模型列表与详情请以模型广场为准。

您也可以通过 API 端点(/maas/v1/models)获取模型列表,详见 GenStudio API 参考文档:

📋 大模型服务平台 API 参考文档