创建模型服务

创建模型服务用于将以下两种来源转化为可在线调用的推理服务:

- 一个成功的在线微调任务。

- 已导入的我的模型资产。

您只需在向导中选择来源、配置资源并提交,平台便会自动完成服务部署,并为您生成一个唯一的部署 ID(格式为 mif-xxxxxxxx)用于后续的 API 调用。

注意

若您需要具体的操作指引,请直接查看对应文档:

- 部署 LoRA 模型服务:来自微调任务或上传的适配器

- 部署完整 SFT 模型服务:全量 SFT、合并后的权重或自训练基座

提示

本功能仅向授权客户开放。非授权客户暂无法使用。如需使用,请联系商务或售后服务。

什么是自部署服务?

自部署服务特指由您自行发起并管理的服务实例。与平台提供的、多租户共享的预置模型 API 不同,自部署服务为您提供独占的计算资源和专属的 API 端点。这使您能够灵活部署自定义模型(例如经过微调或从外部导入的模型),并对其生命周期(如启动、停止)和资源配置拥有完全的控制权。

什么是模型服务?

模型服务是您使用「自部署服务」能力时所创建的具体产物,是指将一个静态的模型资产(例如您上传的权重文件或微调后的产物)转化为一个持续运行、可通过 API 调用的在线推理实例。

每个模型服务都拥有独立的计算资源、唯一的 API 端点和专属的监控视图,确保了服务之间的隔离性与稳定性。

部署与生命周期管理

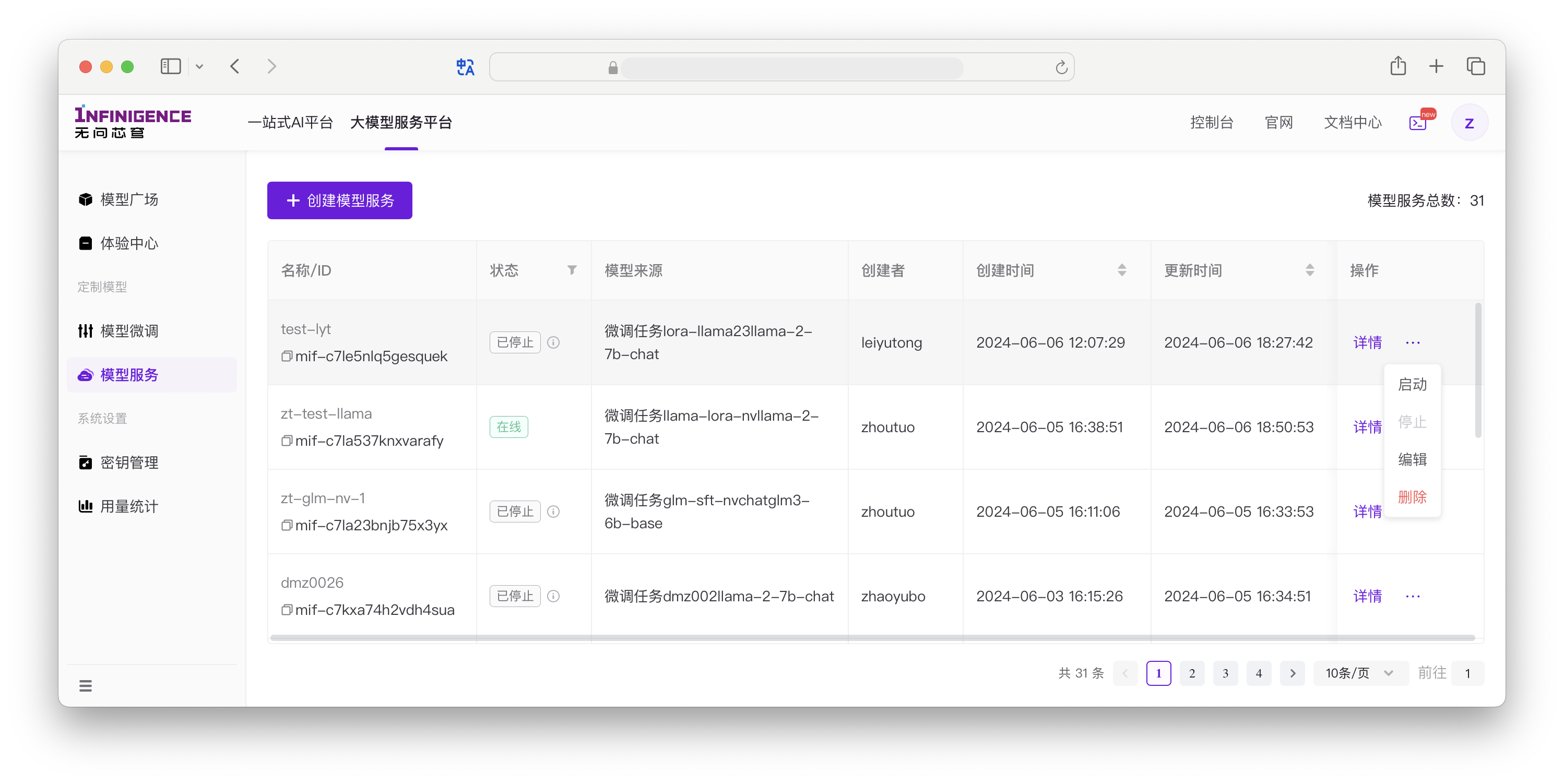

智算云控制台模型服务列表页面展示了所有的自部署模型服务,可以执行以下操作:

- 创建:创建一个模型服务实例。

- 停止:释放底层算力,配置与历史监控仍保留,可再次启动。

- 启动:对已部署(含停止状态)的服务重新拉起实例。

- 编辑:当前支持编辑名称与描述(其余配置需重新创建新服务)。

- 删除:不可恢复,需二次确认。

- 查看详情:进入详情页获取调用地址、实时监控、日志等。

查看模型服务详情

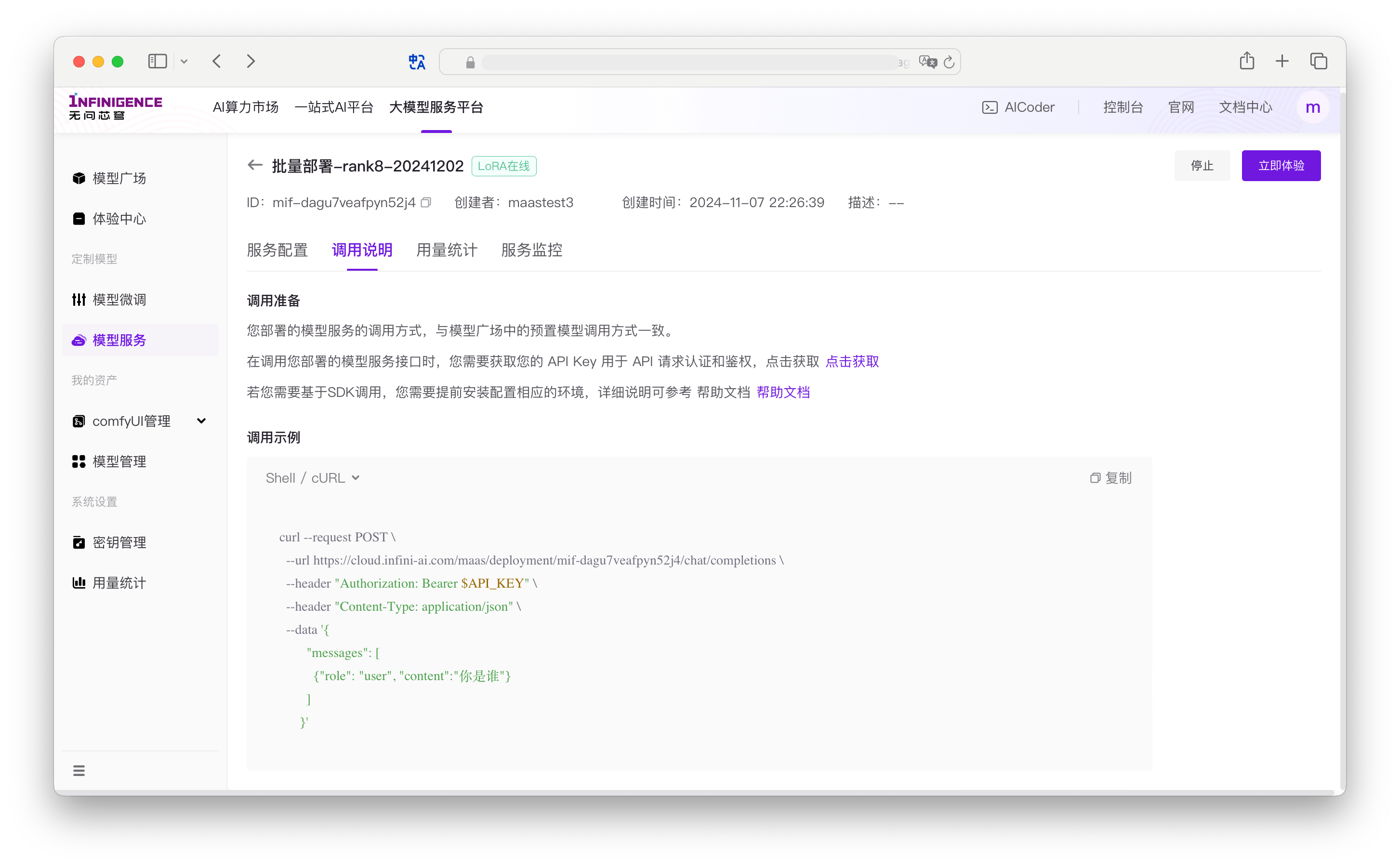

详情页包含以下标签:

- 服务配置:与创建时一致的实例与运行参数。

- 调用说明:获取 API Key 的指引与多语言调用示例。

- 服务监控:业务与系统指标,详见服务监控。

- 服务日志:默认展示第一个实例日志,日志采集周期 10s。

模型资产

若需部署自带或外部来源的文本类模型(例如本地训练 / 其他平台导出),请先执行:

- 准备权重文件、配置文件、分词器等,通过「模型管理」功能上传文本模型资产。

- 上传成功后,在创建模型服务时选择对应资产版本。

监控与日志

- 业务侧关注吞吐、延迟、QPS、失败率等:见服务监控。